Lo scorso venerdì, il 9 dicembre, l’Unione Europea ha approvato l’AI Act, la normativa dedicata all’intelligenza artificiale che, sin dalle prime battute, si è preannunciata come la più grande regolamentazione sulla tecnologia emergente nel mondo occidentale.

Si tratta del primo regolamento al mondo di questo tipo e con una tale portata. Non è ancora definitivo, poiché, dopo l’accordo raggiunto tra Commissione, Consiglio e Parlamento, sono al lavoro i tecnici per un testo finale che sarà votato in modo definitivo dagli organismi comunitari. Questo significa che, se non ci fossero intoppi, potrebbe entrare in vigore tra due anni.

L’Unione Europea ha sottolineato in più occasioni che la normativa ha l’obiettivo di tutelare diritti e libertà, garantendo un bilanciamento tra innovazione e protezione.

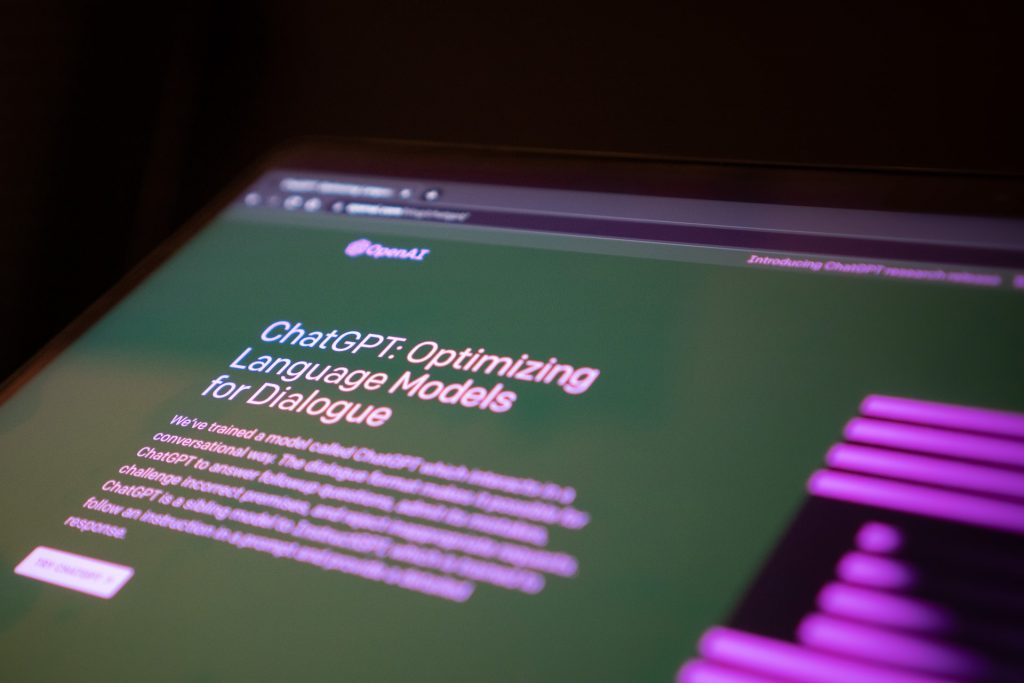

I punti cruciali fanno riferimento, in particolare, a come regolare i modelli di intelligenza artificiale generativa, utilizzati per strumenti come ChatGPT, e l’uso dell’identificazione biometrica, come riconoscimento facciale e scansione delle impronte digitali. Dal nostro punto di vista, ci soffermeremo oggi sul primo aspetto, quello cioè dell’AI generativa. Prima, però, facciamo un piccolissimo salto indietro.

Un po’ di storia…

L’AI Act è il primo nel suo genere che si rivolge specificamente all’intelligenza artificiale e deriva da anni di lavori, il cui inizio si può fare risalire al 2021, quando la Commissione Europea propose per la prima volta un quadro normativo e giuridico comune per l’AI.

La normativa divide l’intelligenza artificiale in diverse categorie di rischio, che vanno da “inaccettabili” a forme ad alto, medio e basso rischio. L’AI generativa è indubbiamente un argomento mainstream già dallo scorso anno, in seguito al rilascio pubblico di ChatGPT da parte di OpenAI. I legislatori, a quel punto, hanno scelto di riconsiderare il loro approccio.

A colpire esperti e regolatori è stata la capacità degli strumenti di intelligenza artificiale generativa di creare output sofisticati e simili a quelli umani, partendo da query semplici e utilizzando grandi quantità di dati. Le preoccupazioni in ballo vanno dalla possibilità di generare linguaggi discriminatori alla violazione della privacy, passando attraverso la perdita di posti di lavoro.

Cosa cambia con l’AI Act?

Con la normativa, l’UE vuole assicurare che diritti e liberà siano al centro dello sviluppo di questa tecnologia, come si legge in una nota: “Questo regolamento mira a garantire che i diritti fondamentali, la democrazia, lo Stato di diritto e la sostenibilità ambientale siano protetti dall’IA ad alto rischio, promuovendo al contempo l’innovazione e rendendo l’Europa leader nel settore. Le norme stabiliscono obblighi per l’IA in base ai rischi potenziali e al livello di impatto”.

Per raggiungere il suo scopo, punta su principi come responsabilizzazione e autovalutazione. Questo significa che, salvo eccezioni, le aziende che producono Ai devono essere in grado di dimostrare che il mondo in cui hanno sviluppato le loro tecnologie non lede i diritti fondamentali e non costituisce un rischio per i cittadini.

Un approccio basato sul rischio

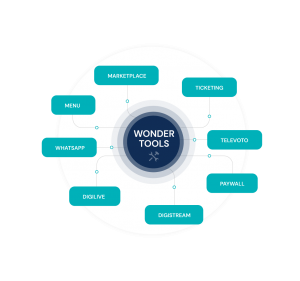

L’approccio è, di fatto, “basato sul rischio” e si concentra sulle applicazioni con un più elevato potenziale di danno. Sono stati disciplinati i sistemi General Purpose (GPAI) che includono i Large Language Models (LLM).

Due i livelli di obblighi. Per tutti è prevista la pubblicazione di una listi dei materiali usati per l’addestramento degli algoritmi – e questo dovrebbe aiutare i produttori di contenuti a tutelare i diritti d’autore e la “riconoscibilità” di ciò che è prodotto tramite AI. Il secondo livello si applicherà ai sistemi che pongono rischi sistemici: prevede valutazioni di questi periodi e delle strategie di mitigazione, oltre l’obbligo di comunicare alla Commissione (che avrà un apposito AI Office) eventuali incidenti.

Per i sistemi di AI classificati come ad alto rischio (a causa del loro significativo potenziale danno alla salute, alla sicurezza, ai diritti fondamentali, all’ambiente, alla democrazia e allo Stato di diritto), sono stati concordati obblighi molto chiari. Gli eurodeputati hanno incluso, tra gli altri requisiti, una valutazione d’impatto obbligatoria sui diritti fondamentali, applicabile anche ai settori assicurativo e bancario.

Anche i sistemi di intelligenza artificiale utilizzati per influenzare l’esito delle elezioni e il comportamento degli elettori rientrano in questa categoria. I cittadini avranno il diritto di presentare reclami sui sistemi di intelligenza artificiale e ricevere spiegazioni sulle decisioni basate su sistemi di intelligenza artificiale ad alto rischio che incidono sui loro diritti.

Poter parlare adesso di conseguenze, è sicuramente prematuro. Possiamo, però, fotografare l’attuale situazione, aprendo la strada a tutte le riflessioni del caso e continuando a seguire con attenzione un dibattito che cresce e chiama in causa sempre più attori.